Définition des deepfakes : comprendre leur fonctionnement, leurs risques et leur détection

De la pornographie à la désinformation politique, les deepfakes sont devenus en quelques années le phénomène technologique le plus flippant de notre époque. Mais que sont-ils vraiment ? Comment fonctionnent-ils ? Quels sont les risques ? On vous explique tout.

Si le terme “révolution numérique” est galvaudé, il n’en reste pas moins le plus approprié pour décrire la déferlante des deepfakes. En l’espace de 2 ans, ces vidéos truquées par IA sont devenues le phénomène technologique le plus fascinant — et le plus flippant — de notre époque. D’un côté, des usages vertueux et bluffants (cinéma, publicité, création de contenus). De l’autre, des dérives aussi sordides qu’inquiétantes (usurpation d’identité, pornographie non-consentie, désinformation politique). Une chose est sûre : les deepfakes ne nous laissent pas indifférents. Mais au fait, c’est quoi un deepfake ? D’où ça vient ? Comment ça marche ? Quels sont les risques ? Et surtout, comment s’en protéger ? Réponses dans notre guide complet.

Deepfake : définition rapide et sans chichis

Qu’est-ce qu’un deepfake ? (Définition IA générative + Fake)

Avoir un deepfake sous les yeux, c’est comme croire que Photoshop est déjà de la sorcellerie. L’utilisateur moyen panique dès qu’un filtre Instagram s’approche trop de la réalité ; alors imaginez la claque quand l’IA générative débarque, armée de réseaux antagonistes génératifs (GANs), pour plier le réel façon origami numérique. Ce n’est pas juste coller une moustache sur une photo. Non. C’est modéliser un visage, singer la voix, injecter des tics nerveux pixel-perfects ! Le deepfake mélange le "deep learning" – ce machin qui apprend à force d’ingurgiter des giga-octets de données — avec le fake pur et dur : résultat, une vidéo ou un audio plus vrai que nature qui ferait passer Houdini pour un amateur.

« Les GANs, ces sorciers numériques, nous refilent plus qu’une simple illusion. »

Un deepfake bien rôdé manipule l’image et le son d’une façon aussi ergonomique qu’une imprimante sans papier : ça roule… jusqu’à ce que tu captes l’arnaque sous le vernis. Bref.

Pourquoi on n’est pas chez Disney : la vérité sur le contraire du bricolage

Attention fantasme d’open space : non, tout deepfake qui claque n’a pas été codé par Kevin, 16 ans, camé au Red Bull dans sa chambre IKEA. Faut arrêter de croire que ce serait du Playmobil numérique où tu colles trois effets spéciaux et tout le monde applaudit. Même si certains pionniers ont bidouillé dans des garages humides, aujourd’hui produire un fake qui ne fait pas grincer des dents demande bien plus qu’un tuto YouTube édenté et deux scripts copiés-collés.

Les vrais deepfakes — ceux qui trompent autre chose que ta grand-mère sur WhatsApp — exigent puissance de calcul, datasets monstrueux et une dose d’ingénierie logicielle qui ferait transpirer même Elon Musk… Bref.

Origines et évolution des deepfakes

Naissance du terme (Reddit, MrDeepFakes)

2017 : un utilisateur anonyme, pseudo "deepfake", balance son algorithme sur Reddit. Le buzz traverse les forums à la vitesse d’un SSD neuf, avec son lot de geeks qui codent dans leur garage, Red Bull en perfusion et imagination en mode turbo. Résultat ? Le mot "deepfake" s’impose aussi vite qu’une fake news sur Twitter, alimenté par des plateformes comme MrDeepFakes qui raffolent du sensationnel. Personne n’était prêt, même pas les modérateurs de Reddit, qui finissent par tirer le rideau face au déluge. Bref.

- 2017 : première apparition sur Reddit

- Projets amateurs dans les garages

- Buzz initial sur Twitter

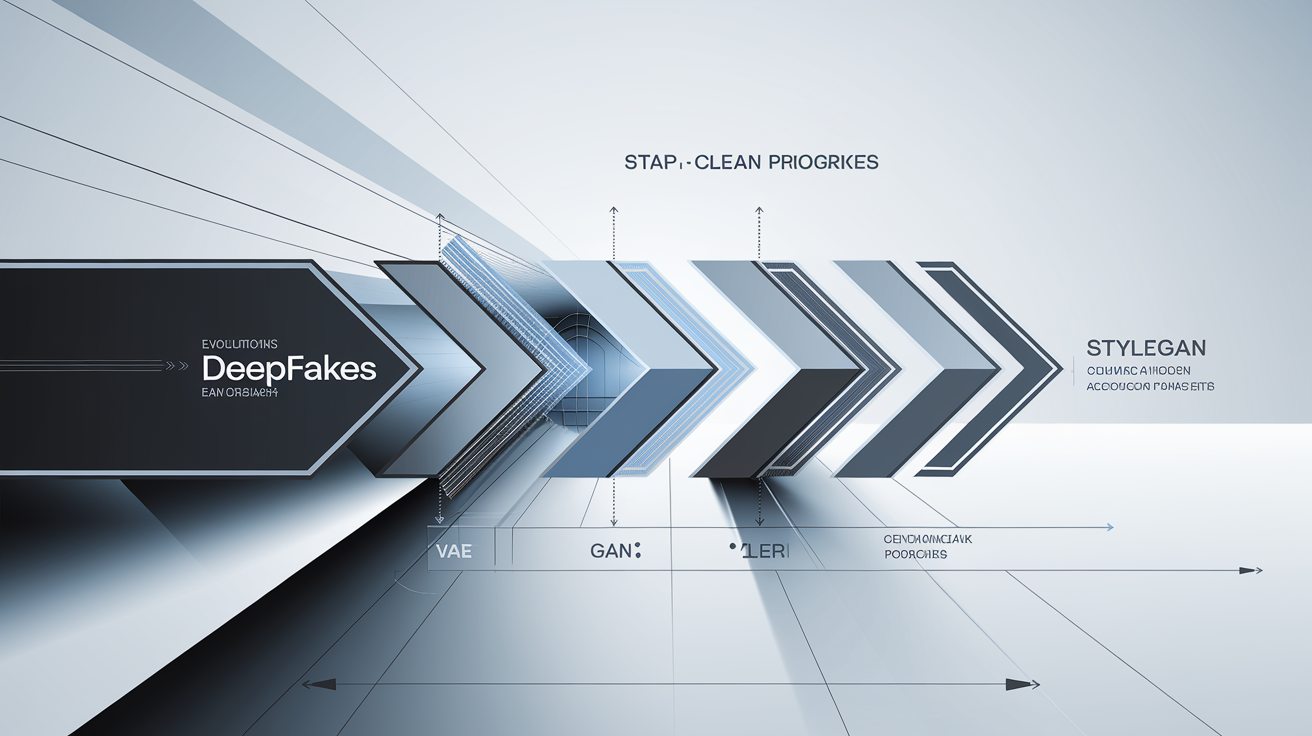

Des premiers auto-encodeurs variationnels aux GANs modernes

Avant de faire frissonner la planète avec des vidéos de politiciens reprogrammés, il a fallu sortir l’artillerie mathématique lourde. Les auto-encodeurs variationnels (VAE), sortis de l’esprit dérangé de Kingma & Welling en 2014, ont amorcé la génération automatique d’images, façon brouillon cosmique pour machine insomniaque. Puis débarquent les GANs (Goodfellow et ses sbires, même année) : deux réseaux qui se tirent la bourre pour berner le réel — le duel algorithmique le plus toxique depuis Alien contre Predator. Nvidia catapulte tout ça en 2018 avec StyleGAN et ses portraits qui font pâlir DALL-E lui-même. On croit rêver… mais non.

| Techno | Année | Contributeur |

|---|---|---|

| VAE | 2014 | Kingma & Welling |

| GAN | 2014 | Goodfellow et al. |

| StyleGAN | 2018 | NVidia |

Moments clés : Obama, Poutine et le Pape passés au filtre

Barack Obama se fait piéger par une vidéo où il insulte Trump… sauf que derrière l’écran c’est Jordan Peele qui parle ! La claque pour la sphère politique mondiale : quatre étoiles sur cinq pour le réalisme, un malaise durable pour les fact-checkers. Poutine ? Moins bling-bling mais tout aussi toxique : des vidéos trafiquées circulent massivement dans les réseaux russes – « deep » désinformation garantie. Le pape François en doudoune blanche ? L’image inonde la toile et fait rire Twitter avant de déclencher quelques sueurs froides côté Vatican. Moralité : ce n’est pas toujours du fun, parfois c’est franchement flippant.

Obama : ⭐⭐⭐⭐✰

Poutine : ⭐⭐⭐✰✰

Pape : ⭐⭐⭐⭐✰

Comment fonctionnent les deepfakes ? Démystification technique

Réseaux antagonistes génératifs : duel de neurones

Imagine deux sorciers numériques, accros au duel sans pitié. Bienvenue dans la fosse aux GANs (Generative Adversarial Networks), où l’illusion règne en despote. Un premier magicien, le Générateur, tente de forger de fausses images capables d’embrouiller un humain lambda aussi sûrement qu’un captcha mal fichu. Son adversaire, le Discriminateur, a pour mission de flairer la supercherie – façon limier obsédé par la vérité visuelle. Ce manège techno continue à coups de back-propagation, chaque erreur servant d’engrais à leur progression mutuelle. L’objectif ? Atteindre la convergence : moment béni (ou maudit) où le Générateur dupe enfin le Discriminateur, créant alors des fakes si convaincants qu’on confond l’original avec la copie. Les GANs sont des sorciers numériques – et pas des petits magiciens de kermesse, non, des vrais dealers de réalité alternative qui ridiculisent tout prestidigitateur du dimanche. Bref.

- Générateur : fabrique des données bidons haut-de-gamme

- Discriminateur : détecte les impostures

- Back-propagation : feedback pour affûter les réseaux

- Convergence : tromperie parfaite (ou presque)

Rôle des auto-encodeurs variationnels et du scraping

Les deepfakes ne sortent pas du micro-ondes avec trois ingrédients mystère. Avant le grand show, il faut « gaver » l’IA grâce à un festin d’images grattées partout sur le Web (scraping massif, oui monsieur). Là-dessus débarquent les auto-encodeurs variationnels (VAE) – ces architectes discrets qui compriment l’essence d’un visage dans un espace mathématique (

pour les intimes : distribution gaussienne). Grâce à eux, on encode et on recompose à volonté : classique chez ceux qui visent la tromperie haut-de-gamme.

Workflow type d’un pipeline deepfake (collecte, entraînement, génération)

Assembler un deepfake digne de ce nom relève davantage de la chaîne de montage brutale que du bricolage du dimanche :

1. Collecte de la data : On ratisse large, parfois même très sale – vidéos HD, selfies volés ou séries Netflix entières passent au hachoir.

2. Nettoyage et labelling : La data se fait ausculter sous toutes ses coutures (yeux fermés = poubelle, mauvaise lumière = blacklist). Sans ce tri clinique, bonjour les visages façon Picasso sous acide.

3. Entraînement du modèle : Le générateur affûte sa plume contre le discriminateur jusqu’à produire un fake qui ne fait plus rire personne… sauf peut-être les ingénieurs du MIT entre deux cafés froids.

4. Génération et post-traitement : On sort alors un deepfake brut ; passage obligatoire par une séance spa numérique : colorimétrie truquée, synchronisation labiale millimétrée et bruit vidéo ajouté histoire de tout rendre "trop vrai pour être honnête".

- Collecte et préparation des données

- Nettoyage expert (ne pas confondre avec lavage auto)

- Entraînement féroce sur clusters GPU affamés

- Post-traitements – là où le fake devient toxique…

On n’est pas chez Disney ici. C’est plus usine clandestine que studio Pixar.

Usages pratiques et dérives dangereuses

Applications légitimes (cinéma, parodies, publicité)

Croire que le deepfake ne sert qu’à piéger des grands-mères sur Facebook, c’est comme penser que Taylor Swift chante tout en playback : une hérésie totale. Derrière le buzz douteux, il y a de vrais cas d’usage qui valent le détour. Hollywood multiplie les doublures numériques pour ressusciter des acteurs disparus ou rajeunir à la truelle les visages de stars fatiguées. La BBC s’amuse avec des parodies à coups de visages remixés, pour titiller la satire et l’esprit critique. Et côté pubs, impossible d’éviter la déferlante : campagnes où IA fait parler la Joconde ou fait rapper Einstein. Bref, la créativité n’a pas attendu les alarmistes.

- Doubles numériques au cinéma

- Parodies comiques

- Spots marketing créatifs

Vidéotox et hypertrucage : la face sombre

On passe du vernis créatif au goudron toxique sans effort : bienvenue dans le règne du foutage de gueule version vidéo. Les deepfakes alimentent un marché noir de la manipulation politique ou de la vengeance privée, avec appels à la haine sur-mesure et fake news prêtes-à-diffuser qui contaminent l’opinion publique plus vite qu’une fuite DNS chez un hébergeur discount.

Fraude financière ? Check. Chantage ? Double check. Certains pays découvrent même la guerre hybride avec des clips montés pour attiser l’incendie social… Bref, bienvenue sur le ring du foutage de gueule.

Fraude à l’identité et synthetic identity fraud

Cerise radioactive sur le gâteau : la fraude à l’identité nouvelle génération explose tout – fintech et iGaming en prennent plein les dents. Proofpoint recense déjà une armée de bots qui créent des identités synthétiques à partir de fragments volés (merci The Verge pour l’anecdote juteuse). Ces avatars factices accèdent aux services bancaires ou blanchissent du fric sale en simulant visage, voix ou papiers.

- Création de faux comptes

- Escroquerie téléphonique deepfake

- Blanchiment new-gen

Risques, détection et parades contre les deepfakes

Signes avant-coureurs : yeux, synchronisation labiale, artefacts

Repérer un deepfake n’est pas plus sorcier que de chasser une licorne sur Twitter : certains indices restent aussi visibles qu’un bug 404 bleu. Premier drapeau rouge : pupilles qui dansent la lambada — souvent, les clignements d’yeux sont absents ou trop robotiques. Ensuite, la synchronisation labiale part en freestyle : paroles et lèvres jouent deux partitions différentes. Ajoutez à ça des artefacts d’encodage (ombres bizarres, textures qui bavent plus qu’un stagiaire sous pression) et vous obtenez le bingo de l’illusion loupée. Bref : un vrai deepfake, c’est rarement du Pixar, souvent du glitch FM.

- Pupilles irrégulières

- Lèvres désynchronisées

- Artefacts d’encodage (pixelisation étrange aux transitions)

Outils de détection (IA de détection, watermarking, artefacts numériques)

On sort l’artillerie lourde pour décaper le fake : IA dédiée façon CNN (Convolutional Neural Network) entraînée à flairer l’intrus pixel par pixel ; watermarking invisible injecté au cœur du média pour traquer la contrefaçon comme un chien truffier sous amphèt’. Ces solutions ne sont pas des baguettes magiques mais elles tabassent déjà fort sur le terrain. TruePic applique son tatouage numérique ; Deepware Scanner ausculte chaque frame à la loupe neuronale. Pas question ici de jouer au détective amateur — c’est du code, du vrai.

| Outil | Méthode | Taux de détection |

|---|---|---|

| TruePic | Watermarking | 85 % |

| Deepware Scanner | IA (CNN) | 92 % |

Législation et éthique : le cadre français et international

Jean-Gabriel Ganascia (CNRS) a dû s’arracher quelques cheveux devant la loi française de 2021 : signalement obligatoire pour tout contenu modifié numériquement. En Europe, le Digital Services Act impose aux plateformes d’étiqueter tout deepfake diffusé — mais sur le terrain ça rame autant qu’une connexion ADSL dans un bunker. Les US bidouillent avec des lois locales : la Californie interdit certains usages politiques. Pour l’éthique ? C’est open bar en débat intellectuel, rien de figé. On n’est pas chez Disney.

- Loi française 2021 : signalement obligatoire des contenus modifiés (Ganascia/CNRS)

- Régulation UE Digital Services Act : marquage systématique sur les plateformes majeures

- Propositions US Congress : patchwork législatif selon les États

Panorama des acteurs et outils incontournables

Plateformes open source et propriétaires (TensorFlow, FakeApp, Adobe Voco)

Bienvenue au bal des puissants : ici, pas question de bidouiller sur Paint version 2002. L’univers du deepfake carbure sur des frameworks open source massifs comme TensorFlow (merci Google pour le gratos… et le tracking qui va avec). Plateforme star de la manipulation neuronale, TensorFlow propulse aussi bien la recherche sérieuse que les scripts d’apprentis illusionnistes en pyjama.

Dans les caves obscures, FakeApp fait figure de boîte à outils maison pour geeks insomniaques : interface rudimentaire, options limitées, mais bonne porte d’entrée pour salir sa carte graphique. Adobe Voco, lui, reste l’arlésienne du fake vocal – prototype qui promettait de cloner une voix avec 20 minutes d’enregistrement avant d’être rangé par Adobe sous clef. Pendant ce temps-là, Midjourney et DALL-E jouent les faussaires visuels en générant portraits et scènes hallucinées sur simple prompt. Le tout saupoudré par Google qui arrose l’écosystème façon pluie acide sur forêt vierge.

- TensorFlow : base open source

- FakeApp : outil amateur

- Adobe Voco : prototype commercial

- Google : chef d’orchestre perfusé aux datas

- Midjourney / DALL-E : génies du faux visuel IA

Communautés et marchés (Reddit, forums iGaming, Fintech)

Des hubs plus underground qu’un data center nord-coréen : voilà où s’échangent les recettes toxiques du deepfake. Sur Reddit, le sub r/deepfakes distribue tutos trash et scripts foireux à une armée de codeurs anonymes – ambiance décontractée entre deux débats sur l’éthique et la prochaine update GPU. Dans l’iGaming ? Les forums privés grouillent de tips pour gruger les systèmes de vérification faciale ; la fintech n’est pas mieux lotie avec des Slack/Discord fermés où circulent identités synthétiques prêtes-à-servir.

Un vétéran raconte avoir vu naître un outil révolutionnaire entre deux canettes de Red Bull dans un garage suintant le silicone brûlé… Comme quoi, certains clichés sont indécrottables.

- Reddit : sub r/deepfakes

- Forums iGaming underground

- Slack & Discord fermés pour insiders only

Rôle des institutions (CNRS, Sorbonne, Open Asso)

Les chercheurs ne vivent pas tous reclus dans leur tour d’ivoire – certains descendent dans l’arène numérique pour dissecquer le monstre. Le CNRS s’impose comme sniper de la détection deepfake grâce à ses modèles IA anti-manipulation (coucou Jean-Gabriel Ganascia). À la Sorbonne, on ausculte autant l’éthique que le code source : analyses sociétales sur la perception du fake et réflexion ouverte sur ses risques démocratiques. Les assos ouvertes type Open Asso balancent ressources libres et guides pratiques contre le fléau – sans effet placebo.

- CNRS : détection AI avancée

- Sorbonne : études éthiques et sociétales

- Open Asso : kits pédagogiques gratuits

Faut-il flipper ou s’en servir ?

Le futur des deepfakes : menace ou opportunité ?

Impossible de trancher entre apocalypse numérique et utopie créative. Les deepfakes sont comme un scalpel : ça soigne ou ça coupe un doigt, tout dépend qui tient le manche. On fantasme souvent la fin de toute vérité, la société basculant dans une orgie de clones vidéo incontrôlables – franchement, aucun expert n’a le bouton stop. Oui, l’incapacité chronique à détecter certains deepfakes va faire couler pas mal d’encre (et ruiner quelques réputations). Mais côté pile, ce même arsenal ouvre des boulevards à l’innovation visuelle, à la mémorisation assistée et au marketing augmenté.

Bref, si vous pensez que c’est une simple menace ou un jouet pour trolls… détrompez-vous. On n’est pas chez Disney : c’est la jungle algorithmique, où chaque nouvel outil prolonge autant l’arnaque que la créativité humaine. Personne ne pilote vraiment – alors accrochez vos ceintures.

Conseils pour rester lucide : formation, vigilance, out-of-the-box

La parade contre le fake parfait ? Ce n’est ni la paranoïa ni le plug-in miracle sorti du chapeau d’un CTO.

Formez vos équipes comme des snipers : sensibilisation sur les signes faibles (pupilles bizarres et lèvres en freestyle), adoption d’outils automatiques (détection IA et watermarking), vérification systématique des sources vidéo avant diffusion — et arrêtez de croire que Google va sauver vos miches.

- Former les équipes

- Mettre en place détection automatique

- Vérifier sources vidéo

- Adopter watermarking

Check-list de survie digitale minimum. Ceux qui négligent ces étapes finiront sur un meme Reddit avant même d’avoir compris pourquoi ils sont dans la sauce. Bref.